El fin de la confianza ciega: cuando el experto que te evalúa es un algoritmo

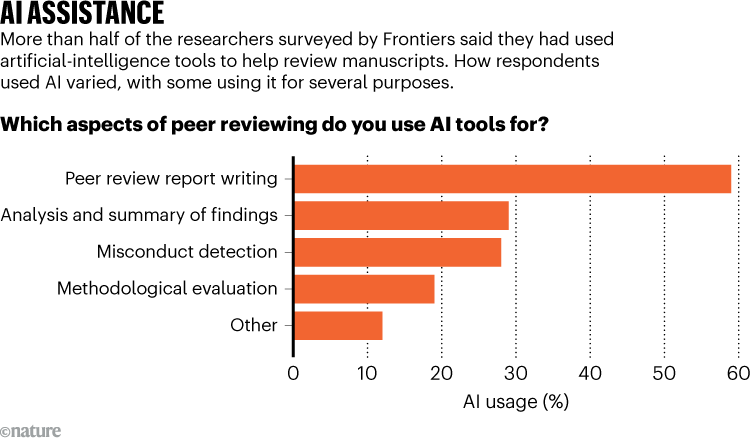

Hace unos días, una encuesta de Frontiers publicada en Nature soltaba una bomba silenciosa en el mundo académico: más de la mitad de los investigadores ya utilizan inteligencia artificial para realizar revisiones por pares. Lo hacen a menudo saltándose las normas de las editoriales y, lo que es más inquietante, subiendo manuscritos confidenciales a herramientas de terceros como ChatGPT.

Esto es terrible, estamos delegando el juicio crítico, el activo más valioso de cualquier profesional, a modelos probabilísticos que, por definición, no entienden lo que están leyendo. Si esto ocurre en la ciencia, el último bastión del rigor, imagina lo que está pasando en los procesos de decisión de tu empresa.

El juicio bajo demanda

Lo que está ocurriendo es un cambio de paradigma en la validación del conocimiento. Durante décadas, el sistema de revisión por pares se basó en un pacto de caballeros: expertos dedican su tiempo de forma altruista a validar el trabajo de otros para asegurar la calidad.

El problema es que el volumen de información hoy es inabarcable. El sistema ha colapsado. Los investigadores, saturados, han encontrado en los LLMs una vía de escape. No es que sean perezosos; es que el sistema les pide ser máquinas y ellos han decidido usar una.

El estudio de Nature revela que el 59% de los que usan IA la emplean para redactar sus informes. Aquí reside el peligro: la IA es excelente imitando la forma de un juicio experto (la estructura, el tono, el vocabulario técnico), pero falla estrepitosamente en el fondo. Se ha demostrado que estos modelos a menudo no detectan errores factuales y carecen de la capacidad para ofrecer críticas constructivas reales.

Puedes descargar el estudio aquí:

Para el directivo o el profesional del marketing, esto es una señal de alarma. Si el “filtro de calidad” de tu ecosistema de contenidos o de tus procesos de innovación está empezando a ser automatizado sin supervisión, el riesgo no es solo el error técnico. Es el ROI emocional: la pérdida de confianza de tu audiencia cuando perciben que detrás de tu marca ya no hay un criterio humano, sino un eco algorítmico.

De la eficiencia a la negligencia

El experimento de Mim Rahimi. El ingeniero Mim Rahimi de la Universidad de Houston decidió poner a prueba a GPT-5 (o las versiones más avanzadas disponibles) con un artículo propio ya revisado por humanos. El resultado fue fascinante y aterrador. La IA generó un informe con un lenguaje pulido y una estructura impecable. Parecía una revisión profesional. Sin embargo, al analizar el contenido, el modelo cometió errores de bulto y no aportó nada a la mejora del trabajo. La forma engañó a la percepción inicial, pero el valor fue nulo.

El Protocolo de Validación Humana (PVH)

Para navegar esta era de “revisión sintética”, propongo un sistema que he implementado en mis propios proyectos de automatización significativa. No se trata de prohibir, sino de estructurar la responsabilidad.

Primero, establece la Trazabilidad del Criterio. No me importa si has usado IA para estructurar un pensamiento, me importa saber en qué punto has aplicado tu experiencia para validar ese output. Si un revisor o un empleado entrega un informe, debe adjuntar una “declaración de intervención”: qué partes ha generado la IA y cómo han sido verificadas.

Segundo, aplica la Auditoría de Matices. Los LLMs son expertos en lo común, pero ciegos ante lo excepcional. En cualquier proceso de revisión, el experto humano debe buscar específicamente lo que la IA suele obviar: la originalidad, el contexto local y la implicación ética. Es lo que llamo proteger la creatividad aumentada.

Tercero, implementa Entornos Seguros. Si el 50% de la gente ya lo usa, dales herramientas corporativas que no comprometan la privacidad. La solución de Frontiers de crear una plataforma in-house es el camino. Si no ofreces una alternativa segura, tus empleados usarán la versión gratuita y pública de ChatGPT, regalando tus secretos comerciales.

Por último, define qué procesos son No-Automatizables. Hay decisiones estratégicas y de identidad que deben estar blindadas contra el algoritmo. El “visto bueno” final a una narrativa de marca o a una investigación científica es una de ellas.

Volviendo al inicio, el mundo científico sí nos está enviando una señal de socorro. Si los guardianes del conocimiento están bajando la guardia, el resto de la industria debe reaccionar.

La IA es la herramienta más poderosa que hemos tenido jamás para expandir nuestras capacidades, pero es la peor herramienta posible para sustituir nuestra integridad. El valor de un experto es su capacidad para distinguir lo que es verdad de lo que simplemente suena bien.

Aquí tienes 5 acciones concretas para mañana mismo:

Auditoría interna rápida: pregunta a tu equipo (sin penalizar) quién está usando IA para validar tareas críticas. Te sorprenderá el porcentaje.

Prohibición de “Cajas Negras”: establece que cualquier informe generado o asistido por IA debe ser declarado explícitamente.

Muestreo de validación: elige tres procesos revisados por IA este mes y haz que un experto senior los revise de cero manualmente para medir la brecha de calidad.

Crea un “Espacio Seguro”: despliega una instancia privada de LLM para que, si van a usar IA, al menos los datos no salgan de la empresa.

Reclama el “Visto Bueno”: asegúrate de que ninguna decisión que afecte a la reputación o la estrategia sea aprobada sin una firma humana que certifique haber leído el documento original, no el resumen.